En informática, cuando se habla de contenedores se hace referencia a un tipo de almacenamiento cada vez más en auge y al que se le augura un futuro brillante. A este respecto, la consultora Gartner ha señalado que el 85% de las empresas usarán los llamados ‘contenedores en producción’ en 2025 cuando en 2019 lo hacían un 35% de ellas.

Además de favorecer el desarrollo de aplicaciones, las plataformas de gestión de contenedores posibilitan su administración y otras acciones clave para cualquier organización como su escalado, duplicación, actualizaciones cuando así se requieran… A este respecto, una de las plataformas más conocidas es Kubernetes a la que se le ha dedicado un espacio en este artículo; de hecho, esta solución de código abierto ha sido el punto de partida para que otras firmas, basándose en la filosofía de Kubernetes, desarrollen sus propuestas.

Kubernetes no es la única, pues existen otras que han ganado notoriedad como Docker y HashiCorp Nomad, también presentes. Junto a estas tres, destaca la participación de Amazon Elastic Container Service, que se integra junto al resto de la plataforma de Amazon Web Services, y Cisco Intersight Kubernetes Service (IKS), una solución SaaS llave en mano que lleva los proyectos Kubernetes en producción a múltiples nubes.

Por su parte, Google Kubernetes Engine es una plataforma administrada por la nube de Google para que las empresas -de igual modo- desplieguen, escalen y gestionen Kubernetes automáticamente. Kubernetes es asimismo el punto de partida de la plataforma HPE Ezmeral Runtime Enterprise, que incorpora un amplio paquete de medidas de seguridad a nivel empresarial.

Microsoft Azure Kubernetes Service ofrece -entre otras opciones- la creación de una aplicación compleja que use aprendizaje automático. Finalmente, se encuentran Oracle Cloud Infrastructure Container Registry (se trata de un servicio de registro Docker) y NetApp Astra Control, una solución de protección y movilidad de datos para aplicaciones que, además de gestionar, protege y ‘mueve’ cargas de trabajo de Kubernetes con una gran cantidad de datos, tanto en entornos on-premises como en nubes públicas.

10 plataformas de gestión de contenedores

Índice de contenidos

Amazon Elastic Container Service

Se integra junto al resto de la plataforma de Amazon Web Services, presentándose como una solución segura que ejecuta cargas de trabajo con contenedores en la nube.

Se integra junto al resto de la plataforma de Amazon Web Services, presentándose como una solución segura que ejecuta cargas de trabajo con contenedores en la nube.

Elastic Container Service (ECS) es un servicio de orquestación de contenedores completamente administrado mediante el cual las empresas implementan, administran y escalan aplicaciones en contenedores. Preparado para poner en marcha cargas de trabajo en contenedores en Amazon Web Services (AWS), las organizaciones interesadas pueden optimizar su tiempo gracias a la capacidad informática sin servidor para contenedores que les facilita AWS Fargate, lo que elimina la necesidad de configurar y administrar el plano de control, los nodos y las instancias disponibles.

En concreto, AWS Fargate es un motor informático que, por sus características, y al permanecer integrado en Amazon ECS, hace que los usuarios no tengan que preocuparse de administrar servidores, manejar la planificación de la capacidad o ahondar en cómo aislar las cargas de trabajo de los contenedores por seguridad. Fargate se ocupa de toda la parte referente a la administración de la infraestructura y el escalado necesarios para ejecutar dichos contenedores. Mientras, y a nivel de seguridad, es posible asignar permisos pormenorizados para cada uno de los contenedores que haya, brindando así un alto nivel de aislamiento al crear aplicaciones. También destaca la incorporación de la función Amazon Elastic Container Service AnyWhere: su propósito es que las compañías ejecuten y gestionen las cargas de trabajo en una infraestructura administrada por el cliente.

La propuesta de Amazon se encuentra preparada para ejecutar y administrar contenedores Docker siendo además compatible con cualquier repositorio de imágenes de Docker alojado por terceros o registro de Docker con acceso privado, así como la administración de contenedores Windows.

Desde el punto de vista de la administración, los trabajadores pueden definir tareas a través de una plantilla de notación de objetos JavaScript (JSON) denominada Task Definition (Definición de tarea). De este modo, en la definición de una tarea, es posible especificar el contenedor o contenedores necesarios para dicha tarea, así como la imagen y el repositorio de Docker, los requisitos de memoria y CPU, los volúmenes de datos compartidos y la forma en que los contenedores están vinculados entre sí. Por su parte, las implementaciones azul-verde con el servicio AWS CodeDeploy ayudan a minimizar el tiempo de inactividad durante las actualizaciones de la aplicación.

De igual modo, hay espacio para la programación de tareas y de servicios, una estrategia de programación que garantiza que se ejecute constantemente un número específico de tareas y que se reinicien si tienen errores. Mediante Amazon CloudWatch se brindan funciones de monitoreo tanto para los contenedores como los clústeres.

Más información: aws.amazon.com/es/ecs

Cisco Intersight Kubernetes Service (IKS)

Esta solución SaaS llave en mano lleva los proyectos Kubernetes en producción a múltiples nubes. Entre otros, se despliega sobre hipervisores VMware ESXi.

Esta solución SaaS llave en mano lleva los proyectos Kubernetes en producción a múltiples nubes. Entre otros, se despliega sobre hipervisores VMware ESXi.

Pocos proyectos de código fuente abierto han sido adoptados tan amplia y rápidamente como Kubernetes (K8s), la plataforma de orquestación de contenedores con la que los equipos de desarrollo despliegan, gestionan y escalan sus aplicaciones en contenedores.

Sin embargo, conlleva también desafíos operativos porque requiere de tiempo y una experiencia técnica para instalar y configurar. De igual modo, es necesario combinar múltiples paquetes de código fuente abierto sobre una infraestructura heterogénea en centros de datos locales, el extremo de la red y, por supuesto, nubes públicas. Y no menos importante: la instalación de Kubernetes y los diferentes componentes de software necesarios, la creación de clústeres, la configuración del almacenamiento, la red y la seguridad, la optimización para IA/ML y otras tareas manuales pueden ralentizar el ritmo de desarrollo y hacer que los equipos pasen horas depurando.

El escenario descrito requiere, por tanto, de una inversión de capital humano dedicado especialmente a actualizar y parchear los errores de seguridad más importantes. Así, IKS, como solución SaaS llave en mano, constituye una plataforma de gestión de contenedores ligera y contrastada para llevar los proyectos Kubernetes en producción a múltiples nubes; formando parte de las ofertas modulares de SaaS Cisco Intersight y simplificando el proceso de aprovisionamiento, seguridad, escalado y gestión de clústeres Kubernetes virtualizados o no. Precisamente, su capacidad para integrarse con el resto de ofertas SaaS de la plataforma Cisco Intersight le ayuda a brindar una potente plataforma de operaciones en la nube para desplegar, optimizar y gestionar el ciclo de vida de la infraestructura, las cargas de trabajo y las aplicaciones de manera fácil y rápida.

También proporciona una automatización de extremo a extremo -incluyendo la integración de redes, balanceadores de carga, paneles de control nativos e interfaces de proveedores de almacenamiento- y funciona con las ofertas más conocidas de K8s gestionadas en la nube pública, integrándose (por otro lado) con el acceso de identidad común con AWS Elastic Kubernetes Service (EKS), Azure Kubernetes Service (AKS) y Google Cloud Google Kubernetes Engine (GKE).

Con una instalación que dura minutos, se despliega sobre hipervisores VMware ESXi, hipervisores Cisco HyperFlex Application Platform (HXAP) y/o directamente en servidores bare metal Cisco HyperFlex Application Platform para un importante ahorro y eficiencia sin necesidad de virtualización. Además, con Cisco HXAP aprovechando las capacidades de virtualización nativa de contenedores, se pueden ejecutar máquinas virtuales (VM), contenedores basados en VM y contenedores bare metal en la misma plataforma.

Más información: www.cisco.es

Docker Swarm

Incluye la administración de clústeres integrada con Docker Engine, el balanceo de carga, opciones de seguridad como el cifrado y la autenticación, y actualizaciones continuas

Incluye la administración de clústeres integrada con Docker Engine, el balanceo de carga, opciones de seguridad como el cifrado y la autenticación, y actualizaciones continuas

Docker engloba un conjunto de productos bajo la ‘fórmula’ plataforma como servicio que emplea la virtualización a nivel del sistema operativo para entregar software en paquetes llamados contenedores. Docker Engine es el software encargado de alojar estos contenedores. Mientras, y al poder ejecutarse en cualquier máquina que incorpore los sistemas operativos Linux, macOS o Windows, Docker facilita que las aplicaciones se ejecuten en una variedad de ubicaciones: instalaciones del cliente, nube pública o nube privada.

Otra característica que lo define es que los contenedores están aislados unos de otros y que agrupan su propio software, bibliotecas y archivos de configuración, pudiendo comunicarse entre sí a través de unos canales definidos. Debido a que todos los contenedores comparten los servicios de un único kernel de sistema operativo, utilizan menos recursos que las máquinas virtuales. Amazon Web Services, Google Cloud Platform, IBM Bluemix o Microsoft Azure son algunos de los servicios con los que se puede integrar.

Teniendo en cuenta el contexto descrito, una de las herramientas disponibles es la que nos ocupa en estas páginas, Docker Swarm, que al agrupar contenedores Docker permite que un grupo de motores Docker se convierta en un único motor Docker virtual. A partir de la versión Docker 1.12, este modo Swarm se encuentra integrado en el software Docker Engine citado antes. Una de sus ventajas es que puede modificar las configuraciones de los servicios, incluidas las redes y los volúmenes a los que se está conectado, sin necesidad de reiniciarlos manualmente. Será Docker quien actualice la configuración, detenga las tareas de servicio con la configuración obsoleta y cree otras nuevas que coincidan con la configuración deseada.

Docker Swarm provee, en otro orden de cosas, de una administración de clústeres integrada con Docker Engine: los usuarios pueden así usar la interfaz de línea de comandos de Engine para crear una multitud de Docker Engine donde implementar servicios de aplicaciones. Por otra parte, para cada servicio, las empresas pueden declarar la cantidad de tareas que desean ejecutar. De este modo, cuando escalan hacia arriba o abajo, el administrador se adaptará automáticamente agregando o eliminando tareas para mantener el estado deseado.

Swarm, que ofrece balanceo de carga y la posibilidad de especificar cómo distribuir contenedores de servicios entre nodos, a nivel de seguridad proporciona medidas que incluyen el cifrado, la autenticación, los certificados raíz autofirmados… Las actualizaciones son continuas. En el momento de la implementación, se puede aplicar actualizaciones de servicio a los nodos de forma incremental.

Más información: www.docker.com

Google Kubernetes Engine (GKE)

Sus características incluyen copia de seguridad de GKE, gestión de acceso e identidades, registro y monitorización, autoescalado, limitación de recursos, aislamiento de contenedores, reparación automática…

Sus características incluyen copia de seguridad de GKE, gestión de acceso e identidades, registro y monitorización, autoescalado, limitación de recursos, aislamiento de contenedores, reparación automática…

Administrado por la nube de Google, Google Kubernetes Engine (GKE) es un servicio que ayuda a las empresas a desplegar, escalar y gestionar Kubernetes automáticamente. A este respecto, la plataforma sobre la que se asienta -preparada para escalar hasta 15.000 nodos- ofrece la posibilidad de eliminar la sobrecarga operativa gracias a un autoescalado en cuatro vías. A nivel de seguridad, propone el análisis de vulnerabilidades de las imágenes del contenedor y el encriptado de los datos.

Ahondando en sus principales prestaciones, lo primero que hay que destacar es que GKE brinda dos modos de operaciones. El llamado ‘estándar’ otorga un control absoluto sobre los nodos, así como la capacidad de ajustar y ejecutar cargas de trabajo administrativas personalizadas. Por su parte, ‘Autopilot’ se perfila como una solución automatizada y totalmente gestionada que se encarga de la infraestructura del clúster para que las empresas no se preocupen ni de su configuración ni de su supervisión.

Dotado de plantillas y aplicaciones comerciales de código abierto creadas por Google para aumentar la productividad de los desarrolladores, los usuarios las pueden desplegar a golpe de clic no solo a través de la modalidad on-premise sino en nubes de terceros desde Google Cloud Marketplace. Destaca, por otro lado, la inclusión de GKE Sandbox, una herramienta que añade una segunda capa de seguridad (y por lo tanto una protección mayor) entre cargas de trabajo en contenedores de GKE. En este caso, los clústeres de GKE son compatibles de forma nativa con la política de red de Kubernetes, de modo que es posible restringir el tráfico mediante reglas de cortafuegos a nivel de pod. Mientras, los clústeres privados de GKE se pueden restringir a un punto final privado o público al que solo tenga acceso un intervalo de direcciones determinado.

Aquellas organizaciones que contemplan la migración de cargas de trabajo tradicionales a contenedores de GKE deben centrarse en Migrate for Anthos and GKE. La herramienta, que traslada aplicaciones desde máquinas virtuales a contenedores nativos, se basa en un sistema que extrae los elementos esenciales de las aplicaciones de las máquinas virtuales para insertarlos en contenedores de GKE o en clústeres de la plataforma Anthos sin ciertas capas de las máquinas virtuales (como el sistema operativo invitado) porque los contenedores no las necesitan.

Para finalizar, apuntar la función de reparación automática. Si está activada y se detecta un nodo que no supera una comprobación del estado, GKE inicia el proceso de reparación del nodo en cuestión.

Más información: cloud.google.com/kubernetes-engine#section-10

HashiCorp Nomad

Además de organizar contenedores, cargas de trabajo heredadas y trabajos por lotes, Nomad permite que las compañías implementen y administren cualquier aplicación en cualquier nube.

Además de organizar contenedores, cargas de trabajo heredadas y trabajos por lotes, Nomad permite que las compañías implementen y administren cualquier aplicación en cualquier nube.

Dentro de la oferta existente en la categoría de plataformas de gestión de contenedores se encuentra también HashiCorp Nomad: se ejecuta como solución binaria única y admite una amplia gama de cargas de trabajo más allá de los contenedores, incluidos Java, Windows, Docker…

Entre sus casos de uso, ofrece una orquestación de contenedores simples para que las organizaciones implementen, administren y escalen contenedores en producción con facilidad. A este respecto, se integra con las herramientas Vault y Consul para habilitar una solución completa y maximizar la flexibilidad operativa, pudiendo escalar a miles de nodos en un solo clúster e implementarse tanto en centros de datos privados como múltiples nubes.

Otro caso de uso es la orquestación de aplicaciones no contenerizadas: el objetivo es implementar y administrar aplicaciones ‘heredadas’ sin necesidad de reescribir o refactorizar. HashiCorp Nomad se encuentra preparada asimismo para gestionar cargas de trabajo perimetrales y cargas de trabajo de procesamiento por lotes con una sobrecarga operativa mínima. En este último ejemplo, el escalador automático de Nomad (o Autoscaler) aprovisiona automáticamente a los clientes solo cuando se pone en cola un trabajo por lotes y los ‘desmantela’ una vez que se completa este trabajo; se ahorra así tiempo y dinero, ya que no hay necesidad de intervención manual.

En lo que respecta a sus características, la plataforma permite a los equipos migrar de forma incremental o almacenar en contenedores las aplicaciones existentes a su propio ritmo con un solo flujo de trabajo de implementación unificado. Además, las organizaciones empresariales la pueden ejecutar como un servicio nativo de Windows gracias al sistema de proceso Service Control Manager y al administrador de servicios Non-Sucking Service Manager, como también por sus siglas NSSM.

Dado que a veces las actualizaciones continuas no ofrecen la flexibilidad necesaria para actualizar una aplicación en producción, las empresas prefieren poner en producción una compilación «canary» o utilizar una técnica conocida como implementación «azul/verde» para garantizar una implementación segura de la aplicación en producción y minimizar el tiempo de inactividad. Esto es lo que sucede con la plataforma HashiCorp Nomad.

Concluimos esta ‘radiografía’ hablando de las herramientas externas que brindan capacidades adicionales y otros casos de uso. Se instalan por separado del propio Nomad y, a veces, se pueden implementar como un trabajo de Nomad en clústeres. Un ejemplo es Levant, que además de admitir la creación de plantillas proporciona comentarios en tiempo real y mensajes de error detallados sobre problemas de implementación.

Más información: www.nomadproject.io

HPE Ezmeral Runtime Enterprise

Su seguridad a nivel empresarial incluye controles integrados con proveedores de identidad como AD/LDAP, inicio de sesión único y alertas proactivas de amenazas, entre otras opciones.

Su seguridad a nivel empresarial incluye controles integrados con proveedores de identidad como AD/LDAP, inicio de sesión único y alertas proactivas de amenazas, entre otras opciones.

Una plataforma de software unificada basada en Kubernetes 100% de código abierto y diseñada para aplicaciones nativas y no nativas de la nube que se ejecutan en cualquier infraestructura local, ya sea en entornos locales o híbridos y de múltiples nubes. Esta es la carta de presentación de Ezmeral Runtime Enterprise, el producto con el que la multinacional norteamericana participa en esta comparativa.

Dentro de este contexto, sus desarrolladores proveen de un avanzado sistema de archivos y de una estructura de datos para un almacenamiento persistente de los contenedores. Y de la misma forma, proporciona a los entornos empresariales la capacidad para poner en práctica cargas de trabajo de inteligencia artificial y análisis no nativos de la nube en contenedores.

Si hablamos de los beneficios que promete, estos se pueden desglosar en cuatro puntos clave. El primero hace referencia al retorno sobre la inversión (es decir, el ROI) porque la solución mejora la utilización de los recursos de hardware al compartir una infraestructura de datos común entre los equipos y las cargas de trabajo. El segundo está vinculado al hecho de que las empresas pueden mejorar su productividad porque las aplicaciones contenedorizadas ofrecen resultados más rápidos y un mayor rendimiento sobre hardware. Por su parte, el empleo de componentes 100 % de código abierto y API abiertas (tercera ventaja) facilita que las organizaciones elijan sus aplicaciones y datos (‘moviéndolos’ si así lo requieren) sin necesidad de refactorizar. Finalmente, Ezmeral Runtime Enterprise proporciona una gestión y control de privilegios que están basados en una serie de políticas: el propósito es definir y adaptar accesos, niveles de confianza y privilegios para las personas, los equipos y los espacios de datos.

En lo que respecta a sus características, es compatible con la importación de clústeres de proveedores de la nube como Amazon EKS, Google GKE y Azure AKS. De igual modo, asegura una implementación, gestión y supervisión sencillas de clústeres de Kubernetes de forma local o remota para la gestión mediante un panel único y visibilidad en todos los entornos. Desde un enfoque de seguridad empresarial cuenta con: controles de seguridad integrados con proveedores de identidad como AD/LDAP, inicio de sesión único, integración de SAML, controles de acceso basado en roles para una entrada segura a la plataforma, alertas proactivas de amenazas… Gracias a la capa de datos unificados HPE Ezmeral Data Fabric, los usuarios ‘conectan’ con estos datos y los gestionan con independencia de su ubicación.

Más información: www.hpe.es

Kubernetes

Diseñado originariamente por Google, Kubernetes es un sistema de código abierto que agrupa los contenedores que componen una aplicación en unidades lógicas para facilitar su gestión.

Diseñado originariamente por Google, Kubernetes es un sistema de código abierto que agrupa los contenedores que componen una aplicación en unidades lógicas para facilitar su gestión.

Conocido también con el nombre de K8s, Kubernetes se basa en la experiencia acumulada durante 15 años por Google en lo que respecta a la ejecución de cargas de trabajo de producción. El proyecto, que fue liberado en 2014, se sustenta en un sistema de código abierto que automatiza la implementación, el escalado y la gestión de aplicaciones en contenedores. Los usuarios pueden, a este respecto, aprovechar en función de sus necesidades una infraestructura de nube pública, híbrida o local.

Como entorno de administración centrado en contenedores, Kubernetes articula la infraestructura de cómputo, redes y almacenamiento. Sugiere, dentro de este escenario, etiquetas para que los recursos puedan organizarse mucho mejor, así como anotaciones con las que asignar información a un recurso para facilitar los flujos de trabajo. Por otro lado, y dado que el plano de control de Kubernetes emplea las mismas APIs que utilizan los usuarios finales y desarrolladores, estos pueden escribir sus propios controladores usando sus propias APIs desde una herramienta de línea de comandos.

Con despliegues y reversiones automatizadas, la plataforma permite que las empresas administren sus cargas de trabajo por lotes y CI, reemplazando los contenedores que fallan. De igual modo, concede a los pods -este término se emplea para describir las unidades de computación desplegables más pequeñas que se crean y gestionan en la plataforma- sus propias direcciones IP y un solo nombre de DNS para un conjunto de pods, pudiendo equilibrar la carga entre ellos.

Otra característica a indicar es que las empresas pueden colocar contenedores automáticamente en función de sus requisitos de recursos y otras limitaciones, sin sacrificar para ello la disponibilidad. También destaca la posibilidad de agregar funciones a los clústeres de Kubernetes sin necesidad de modificar el código fuente original, y el escalado horizontal: gracias a esta funcionalidad, los trabajadores escalan hacia arriba o hacia abajo sus aplicaciones a través de un comando simple, interfaz de usuario o automáticamente según el uso de la CPU.

En lo que a orquestación de almacenamiento se refiere, Kubernetes permite que a las compañías montar automáticamente el sistema de almacenamiento que elijan, ya sea desde un almacenamiento local, un proveedor de nube pública o un sistema de almacenamiento en red como NFS, iSCSI, Gluster, Ceph, Cinder o Flocker. Admite, por otro lado, el reinicio de contenedores en caso de fallo, su reemplazo y reprogramación cuando los nodos ‘mueren’, y la eliminación de aquellos que no responden a su verificación de estado definida por el usuario

Más información: kubernetes.io

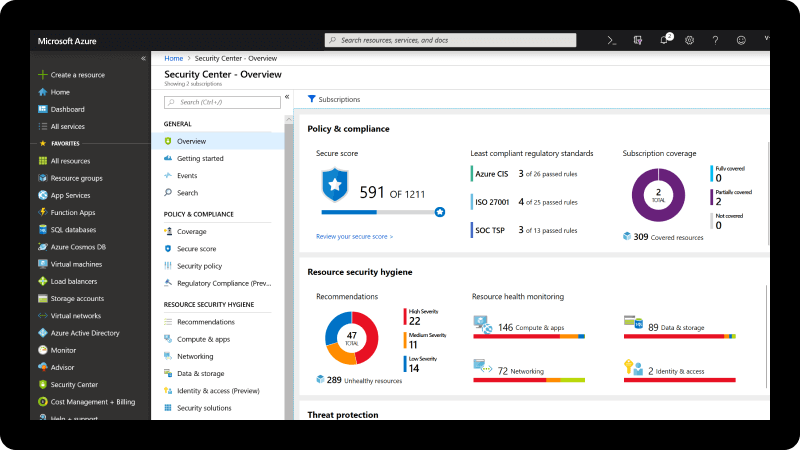

Microsoft Azure Kubernetes Service

Permite migrar aplicaciones a la nube, crear una aplicación compleja que use aprendizaje automático o aprovechar la agilidad que ofrece la arquitectura de microservicios.

Permite migrar aplicaciones a la nube, crear una aplicación compleja que use aprendizaje automático o aprovechar la agilidad que ofrece la arquitectura de microservicios.

El gigante de Redmond participa con Azure Kubernetes Service (AKS). Se trata de un servicio administrado de orquestación de contenedores disponible en la nube pública de Microsoft Azure y basado en el sistema de código abierto Kubernetes.

Teniendo en cuenta el marco en el que se sitúa, una organización puede usar AKS para implementar, escalar y administrar los contenedores de Docker. También las aplicaciones que están basadas en contenedores en un grupo de hosts de contenedores. El servicio, totalmente administrado, no solo facilita la implementación y la administración de las aplicaciones en contenedores: las empresas pueden, asimismo, obtener una administración y una gobernanza unificada para Kubernetes locales, perimetrales y multinube, así como una interoperabilidad con los servicios de seguridad, identidad, administración de costos y migración de Azure.

En lo que referente a sus características, AKS proporciona un aprovisionamiento elástico de capacidad sin necesidad de administrar la infraestructura, pudiendo agregar desencadenadores y un escalado automático controlado por eventos mediante KEDA (del inglés Kubernetes-based Event Driven Autoscaling). Este componente liviano y de un solo propósito puede agregarse a cualquier clúster de Kubernetes, resultando compatible con diferentes tipos de cargas de trabajo.

El servicio de Microsoft brinda, en otro orden de cosas, una experiencia de desarrollo ‘de un extremo a otro’ más rápida con las herramientas de Kubernetes de Visual Studio Code, un editor de código redefinido y optimizado para crear y depurar aplicaciones web y en la nube; Azure DevOps, antes conocido como Visual Studio Team Services, este producto proporciona control de versiones, informes, gestión de requisitos y proyectos, compilaciones automatizadas…; y Azure Monitor que ayuda a maximizar la disponibilidad y el rendimiento de las aplicaciones y los servicios. AKS provee, asimismo, de capacidades de autenticación y autorización utilizando Azure Active Directory y aplicando reglas dinámicas entre varios clústeres con Azure Policy.

Uno de los beneficios a destacar es que los usuarios acceden a través de un portal de administración de AKS, una interfaz de línea de comandos (CLI) de AKS o el uso de plantillas Azure Resource Manager (ARM). Además, los nodos AKS pueden escalar hacia arriba o hacia abajo para adaptarse a las fluctuaciones en las demandas de recursos. Por otro lado, configura automáticamente todos los maestros y nodos de Kubernetes durante el proceso de implementación y maneja otras tantas tareas como la integración de Azure Active Directory, las conexiones a los servicios de monitoreo y la configuración de funciones de red avanzadas (por ejemplo, enrutamiento de aplicaciones HTTP).

Más infotmación: azure.microsoft.com/es-es/services/kubernetes-service

Oracle Cloud Infrastructure Container Registry

‘Construido’ con almacenamiento de objetos, proporciona durabilidad de los datos y alta disponibilidad del servicio con replicación automática en los dominios de fallos, entre otras características.

‘Construido’ con almacenamiento de objetos, proporciona durabilidad de los datos y alta disponibilidad del servicio con replicación automática en los dominios de fallos, entre otras características.

Es un servicio de registro Docker gestionado por Oracle y basado en estándares abiertos para almacenar y compartir imágenes de contenedores de forma segura. A este respecto, los ingenieros insertar y extraer imágenes Docker con la interfaz online de comandos (CLI) y la API conocidas de Docker. Para admitir los ciclos de vida de los contenedores, funciona con Container Engine for Kubernetes, Identity and Access Management (IAM), Visual Builder Studio y herramientas de desarrollo y DevOps de terceros.

En lo referente a sus funcionalidades, brinda actualizaciones automáticas ya que Oracle se encarga de operar el servicio y aplicar parches para que los desarrolladores puedan crear e implementar aplicaciones en contenedores. Además, se contempla un servicio gratuito que incluye soporte empresarial: significa que los usuarios pagan únicamente por los recursos asociados de almacenamiento y red consumidos.

Con respecto a la protección de datos, Cloud Infrastructure Container Registry –que está construido con almacenamiento de objetos– garantiza tanto su durabilidad como una alta disponibilidad del servicio con replicación automática en los dominios de fallos. Si ahondamos en sus prestaciones de seguridad, la solución permite la utilización de repositorios de contenedores privados y políticas detalladas para compartir imágenes dentro de las regiones comerciales de Oracle Cloud Infrastructure o la utilización de repositorios públicos para compartir imágenes con cualquier persona a través de Internet.

De igual modo, protege las imágenes con cifrado SSL de extremo a extremo, aprovechando la autenticación de token del registro de Docker V2 integrada y cumpliendo con estándares destacados de la industria como HIPAA, PCI y SOC 2. Por su parte, el control de acceso para la capacidad de gestión permite su integración con las políticas de control de acceso de Identity and Access Management (IAM) que ofrece seguridad y gestión de identidad, entre otros beneficios.

Destacan, por otro lado, las implementaciones rápidas en Kubernetes para crear repositorios de contenedores ubicados con Container Engine for Kubernetes (un servicio de orquestación de contenedores) en cualquier región comercial para implementaciones de imágenes de baja latencia. También su flexibilidad para desarrollar e implementar aplicaciones nativas en la nube utilizando Container Registry a través del entorno de desarrollo virtual Oracle Visual Builder Studio u otras herramientas de CI/CD como Jenkins y GitLab; su capacidad para alojar hasta 500 repositorios de contenedores, cada uno con 100.000 imágenes por cada región; y el empleo de políticas de retención para limpiar automáticamente las imágenes Docker antiguas de los ciclos de lanzamiento rápidos.

Más información: www.oracle.com/es

NetApp Astra Control

Gracias a Astral Control, NetApp proporciona a los negocios cargas de trabajo de Kubernetes donde se incluyen diferentes servicios de protección de datos para aplicaciones.

Gracias a Astral Control, NetApp proporciona a los negocios cargas de trabajo de Kubernetes donde se incluyen diferentes servicios de protección de datos para aplicaciones.

De la mano de NetApp, llega la plataforma de gestión y control del ciclo de vida de aplicaciones basadas en contenedores Astra Control. Se presenta como una solución de protección y movilidad de datos para aplicaciones que, además de gestionar, protege y ‘mueve’ cargas de trabajo de Kubernetes con una gran cantidad de datos, tanto en entornos on-premises como en nubes públicas. Así, el hecho de que se encuentre disponible como servicio totalmente gestionado y como software auto-gestionado on premises pone de manifiesto su flexibilidad adaptándose no solo a las aplicaciones más pequeñas. También a las cargas de trabajo mayores que puedan existir en el mundo de la empresa.

Le caracteriza, por otra parte, su amplio conjunto de servicios de gestión de datos para aplicaciones. Dentro de este contexto, NetApp Astra Control permite que los trabajadores realicen backups, efectúen labores de restauración, migren aplicaciones entre clústeres y nubes, y creen clones de aplicaciones que funcionen.

Estas copias de seguridad destacan porque son personalizadas y automáticas; además, es posible realizar un backup completo de las aplicaciones y su estado que se pueden usar precisamente para restaurar estas aplicaciones con sus datos en otro clúster de Kubernetes, en la misma región o en otra diferente. Junto al cifrado de datos -según la configuración de protección que elija la empresa- con Astra Control se llevan a la práctica copias Snapshot para aplicaciones y, de esta manera, proteger los datos locales. En el supuesto de que los datos se eliminan o son corrompidos por accidente, la plataforma está preparada para revertir las aplicaciones y los datos asociados a una copia Snapshot que previamente ha sido grabada en el mismo clúster de Kubernetes.

En otro orden de cosas, sus desarrolladores han creado una consola unificada para las operaciones de gestión de datos y catálogo de cualquier aplicación. Mientras, y con el objetivo de facilitar y simplificar la gestión de la protección de datos, es posible visualizar de manera clara cómo se encuentra el estado de su protección, así como los registros de actividades, entre otras posibilidades.

En el caso de optar por el servicio totalmente gestionado (Astra Control Service) es posible elegir entre las siguientes opciones: un plan gratuito limitado a 10 aplicaciones, un plan Premium con aplicaciones ilimitadas y una suscripción Premium. Si se prefiere el servicio autogestionado (Astra Control Center), NetApp pone a disposición de las organizaciones interesadas una suscripción de software.

Más información: www.netapp.es