Acceder de manera uniforme a fuentes de datos distribuidas y heterogéneas es clave para conseguir industrias autónomas. Esto puede lograrse gracias a una arquitectura que permite el tratamiento uniforme de los datos con independencia del origen, ubicación y destino.

La piedra angular sobre la que pivotan todos los sistemas de Machine Learning es poder cubrir de forma sencilla el ciclo de vida completa del dato, donde es importante tener en cuenta tanto la recolección, análisis, obtención de algoritmos como su aplicación práctica. Teniendo en cuenta todos estos elementos, es posible evolucionar de una metodología basada en procesos automatizados a una basada en procesos autónomos y, por lo tanto, más adaptable a los nuevos entornos de fabricación. Los objetivos más típicos de esta aproximación son la mejora de la eficacia y establecer nuevas empresas digitales.

Un ejemplo de ello es el mecanizado, donde los procesos de machine learning pueden medir en tiempo real la calidad de la superficie de una pieza, y en base a algoritmos y reglas dinámicas, se pueden generar recomendaciones y acciones automáticas, tales como la clasificación de la pieza, el ajuste de los pasos de producción o la optimización del proceso de fresado.

Para ello, cada industria en particular debe modelar digitalmente la lógica y recursos de producción (gemelo digital), para poder obtener en tiempo real parámetros de calidad y gestión, que habiliten la correlación continua entre distintos sistemas y permitan generar nuevos modelos que mejoren el control, y optimicen el proceso global de producción.

Hasta aquí la teoría. En la práctica, las compañías de fabricación se enfrentan a un dilema que surge a raíz de los requisitos del ciclo del dato.

Ciclo del dato desde la plataforma de producción a la plataforma centralizada

La calidad de los modelos de datos depende en gran medida de la cantidad y calidad del «material de aprendizaje». A un técnico, puede llevarle años de experiencia conocer el comportamiento exacto de una sola fresadora con el objetivo de poder identificar o evitar un mal funcionamiento previo a que este suceda. Si se pudiera agregar la experiencia con cientos o miles de fresadoras similares, el proceso de aprendizaje podría reducirse a semanas o días.

De forma análoga esto es lo que sucede cuando se recogen datos de máquinas similares, pero de diferentes lugares, y se introducen en un modelo de Machine Learning. Cuantos más datos relevantes estén disponibles, más rápido y mejor será el proceso de aprendizaje. Esto se conoce como efecto data network.

Los datos industriales en particular tienen un potencial considerable para crear ventajas competitivas sostenibles. Pero no sólo los datos que intervienen directamente en el proceso de fabricación son necesarios para la formación de modelos de aprendizaje, hay que ir un paso más allá. Por este motivo, y continuando con el ejemplo del mecanizado, los datos que intervienen directamente en el proceso de fabricación serían: la rugosidad de la superficie, el proceso de fresado, la alimentación eléctrica o la profundidad de corte, pero también sería importante contar con los valores medidos de la propia fresadora (vibración), la información ambiental (temperatura y humedad), así como los parámetros logísticos y comerciales.

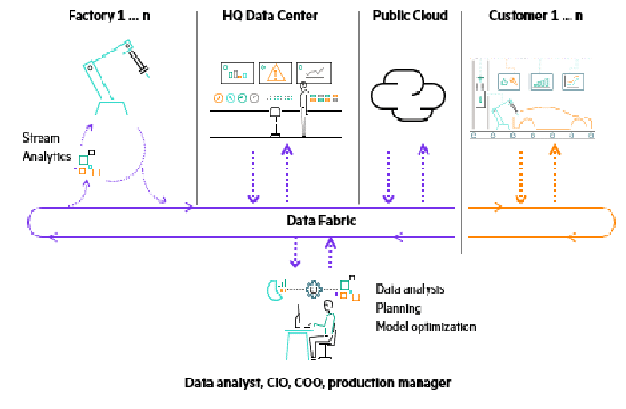

Los modelos de entrenamiento dan como resultado algoritmos y reglas que se aplican a la producción de forma continuada. Según el proceso, esto puede requerir desde tiempos de respuesta bajos (latencia) o incluso exigir un procesamiento en tiempo real. Por ello, el análisis de datos se suele realizar en las propias fábricas, lo más cerca posible del origen, utilizando sistemas que actúan como interfaz entre los sistemas industriales y los sistemas TI. Estos entornos aseguran que el análisis y la acción puedan tener lugar sin transferencia de datos a centros remotos, o la nube, para asegurar la mayor estabilidad posible del proceso.

Además, como complemento a lo anterior, también hay un flujo de datos constante entre las diferentes plantas de fabricación y las sedes centralizadas, para que se haga un procesamiento global y lograr inferir mejoras teniendo en cuenta el conjunto de entornos.

Eliminar las islas de datos y dependencias

Para construir estos modelos a lo largo de toda la cadena de valor, los datos deben gestionarse tanto vertical como horizontalmente. Con la integración vertical de las máquinas o sistemas, se transmite la información a plataformas IoT centralizadas o cloud. Esto puede ser, por ejemplo, la temperatura y vibración, son muestreadas y visualizadas o procesadas, en un sistema centralizado.

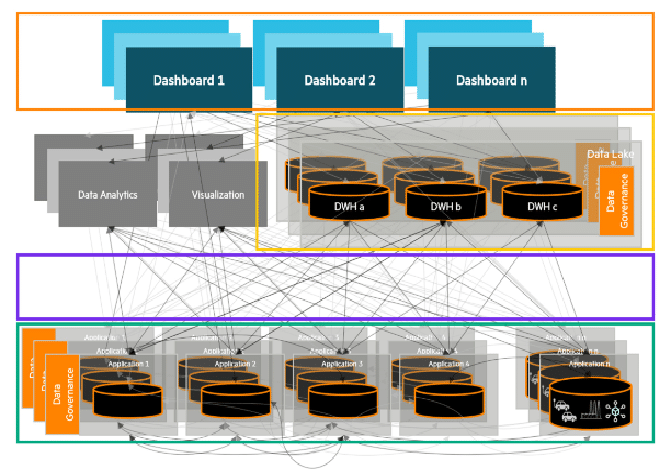

Al hacer esto, las industrias se enfrentan al dilema de utilizar soluciones IoT específicas para cada una de sus máquinas que permitirán obtener una información muy detallada de ellas, pero a la vez crearán islas de datos que dificultarán el análisis y el control del conjunto de la producción. La complejidad que ya existe en los entornos de fabricación se consolida o aumenta aún más, es decir, la típica «arquitectura espagueti» en la que varias bases de datos, herramientas de análisis y aplicaciones se entrecruzan a través de interfaces individuales. Por otra parte, si las empresas sólo dependen de una, o de unas pocas plataformas cloud para reducir la complejidad, la dependencia de esas plataformas aumentará.

Las industrias se enfrentan al dilema de utilizar soluciones IoT específicas para cada una de sus máquinas

La integración horizontal puede resolver estos problemas. Con este enfoque, los datos no se transfieren a una ubicación central, sino que se vinculan entre sí mediante una capa de datos separada. De ahí el concepto Data Fabric.

Control del ciclo del dato mediante Data Fabric

Por un lado, Data Fabric combina sistemas de archivos distribuidos y heterogéneos a través de la abstracción que nos dan los name spaces, que pueden ser únicos o globales. Como resultado, las empresas de fabricación obtienen un acceso uniforme a los datos y archivos que pueden ser distribuidos a través de una amplia gama de sistemas y en tantas localizaciones como sea necesario. Esto permite una gestión global de los datos, que proporciona, entre otras cosas, un control granular del acceso y la seguridad de los mismos. El Data Fabric también organiza el ciclo de datos descrito anteriormente, siendo el eje a través del cual las plantas de producción, los servicios en la nube y las compañías asociadas se integran en este ciclo como proveedores, o receptores de datos y modelos analíticos.

Con este enfoque se puede reducir significativamente la complejidad, porque hay un acceso consolidado a los datos. Además, la interacción entre las aplicaciones, las fuentes de datos y las bases de datos es organizada mediante una capa uniforme. También se resuelve el problema de la dependencia porque las industrias controlarán el ciclo, es decir, no son las plataformas externas las que integran a los clientes como una araña en su propia red. Incluso cuando se utilizan múltiples plataformas externas, se preserva la uniformidad de la arquitectura de datos. De este modo, una compañía puede reducir adicionalmente su dependencia mediante una estrategia de múltiples proveedores sin tener que temer una complejidad excesiva o islas de datos.

Elementos de un Data Fabric

Data Fabric está basado en una arquitectura abierta y transparente. A continuación, se describen los componentes que destacan en los procesos de adquisición, agregación, análisis y acción:

- Adquisición: La adquisición de datos se realiza mediante módulos software que acceden a los datos a través de interfaces de programación de aplicaciones. Puede tratarse de la base de datos SQL del sistema ERP, los datos del sensor de una fresadora o la base de datos NoSQL de una aplicación cloud. Los módulos de software convierten los respectivos protocolos y así integran la variedad de fuentes de datos.

- Agregación: Los datos se envían desde los sistemas origen al Data Fabric a través de pipelines para hacerlos accesibles a las aplicaciones de destino mediante sistemas de mensajería. En este contexto, los datos suelen seleccionarse y comprimirse, ya que no todos los datos de las fuentes suelen ser relevantes para el procesamiento final. Además, los datos pueden almacenarse en el conocido datalake. El datalake agrega las fuentes de datos heterogéneos relacionados con la producción a fin de crear la mayor base de datos posible para alimentar los modelos de Machine Learning. A diferencia de un data warehouse tradicional, el datalake puede distribuirse en varias localizaciones y entornos, como por ejemplo fábricas, centros de datos o nubes. El control multi-tenant decide qué usuarios pueden acceder a qué datos, y de qué manera. Esto significa que el datalake distribuido también puede ser usado a través de varias compañías sin afectar a la soberanía de los datos de las empresas involucradas.

- Análisis: Utilizando las mismas fuentes, los analistas pueden acceder tanto a los datos operacionales en circulación como al datalake distribuido para experimentar con los modelos y así entrenarlos, perfeccionarlos y actualizarlos continuamente. Utilizando stream analytics (análisis en tiempo real de las fuentes), los modelos entrenados son posteriormente utilizados para monitorizar los datos de los sensores de producción en curso. Por ejemplo, se pueden reconocer desviaciones o comportamientos llamativos que indiquen fallos de funcionamiento. Stream analytics es la base para la realización de acciones autónomas en las operaciones, así como para intervenciones más a medio plazo, como el mantenimiento predictivo.

- Acción: Las acciones se desencadenan en base a algoritmos o lógicas de negocio, como en una industria lo sería la apertura de una orden de soporte si una máquina se prevé que falle, debido al desgaste, y deja de producir con la calidad deseada. Además, los procesos posteriores pueden adaptarse, en base a este conocimiento, para mantener la calidad dentro de un rango de tolerancia. Esto se denomina sistemas auto-optimizados o autónomos.

Los contenedores como base tecnológica

El uso de contenedores se utiliza como base tecnológica en Data Fabric. Esto permite que la lógica de negocio del Data Fabric pueda estar distribuida entre las sedes de producción, logística, los centros de datos y las nubes, mientras que son operados de manera uniforme. Los contenedores y la orquestación de éstos con Kubernetes son el medio elegido hoy en día para construir aplicaciones distribuidas e independientes de la plataforma. El problema de la persistencia de los datos también se puede resolver hoy en día, de modo que las aplicaciones monolíticas – como MES o PPS – pueden ser desplegadas en contenedores. Esto ofrece a las empresas un entorno homogéneo con las correspondientes ventajas en eficiencia y transparencia en el funcionamiento.

Cuando se construye un Data Fabric de este tipo, cada empresa debe responder a la pregunta de construirlo o comprarlo. Hoy en día, hay una gran variedad de tecnologías y herramientas open source disponibles que las empresas pueden utilizar para construir su propio Data Fabric, pero implica aumentar la complejidad. Como gran alternativa está HPE Ezmeral Data Fabric. Este es un sistema de archivos distribuidos, y masivamente escalable con el que los volúmenes de datos del rango de petabytes pueden ser manejados con sencillez y alto rendimiento.

Esto es una característica básica de HPE Ezmeral Container Platform, que se utiliza para construir Data Fabrics y permite el despliegue de aplicaciones sobre contenedores. La plataforma también soporta el análisis de fuentes de datos distribuidas y además permite el almacenamiento persistente de datos en entornos de contenedores.

Conclusión

Con Data Fabric las industrias pueden crear la plataforma necesaria para liberar el potencial que ofrece el conocimiento de sus datos, permitiendo una mayor eficiencia operacional o facilitando crear una plataforma que ofrezca servicios digitales a sus clientes. El Data Fabric desbloquea este potencial de los datos, mejorando el intercambio y el control de los mismos, además de facilitar la mejora en la lógica de los procesos. También las fuentes de datos externas pueden ser aprovechadas, e incluso pueden ser accedidas por terceros mediante acceso controlado al Data Fabric, lo que permite crear una red de compañías que exploten el conocimiento de los datos.

Con este enfoque, las empresas siguen siendo en gran medida independientes de las plataformas IoT o cloud, porque desbloquean la posibilidad de una red de colaboración mediante una arquitectura descentralizada y de la que se tiene un control total.

Por Galo Montes, director de tecnología de Hewlett Packard Enterprise